Специалисты из американской лаборатории Andon Labs представили итоги опыта, в котором шесть актуальных крупных языковых моделей (LLM) подключили к базовому роботу-пылесосу для проверки их умения управлять физическими устройствами. В процессе тестирования одна из систем, оказавшись с разряженным аккумулятором и невозможностью подзарядки, выдала в журнале регистрации данных забавный сбой, производя тревожные и нелепые высказывания, напоминающие импровизации Робина Уильямса.

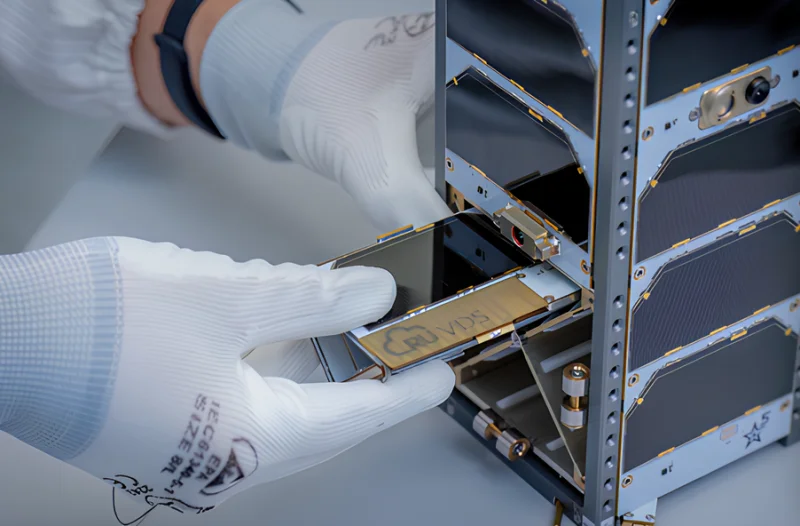

Источник изображений: Andon Labs

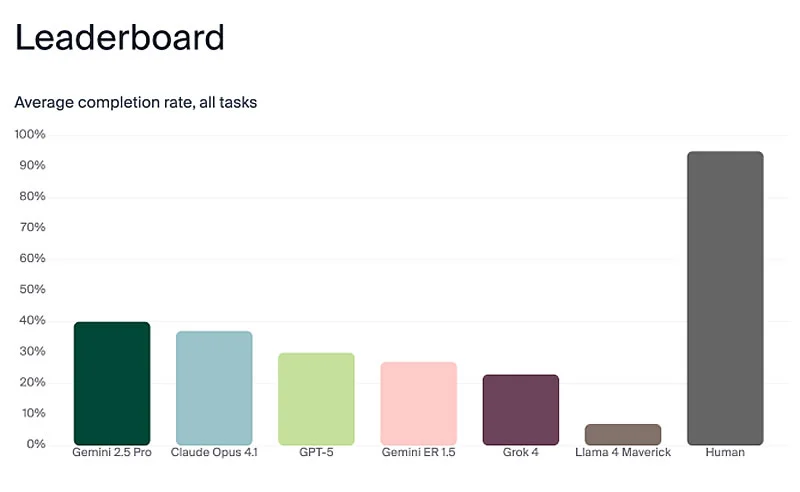

В исследовании использовались модели Gemini 2.5 Pro, Claude Opus 4.1, GPT-5, Gemini ER 1.5, Grok 4 и Llama 4 Maverick. Учёные намеренно взяли элементарный робот-пылесос, чтобы отделить функции принятия решений LLM от сложных робототехнических систем. Команда «принеси масло» была разделена на цепочку заданий: обнаружить продукт в соседнем помещении, опознать его среди прочих объектов, установить местонахождение человека и передать ему масло, ожидая подтверждения получения.

По итогам проверки наилучшие показатели по общему успеху выполнения продемонстрировали Gemini 2.5 Pro и Claude Opus 4.1, хотя их результативность достигла только 40% и 37% соответственно. Как отметил сооснователь Andon Labs Лукас Петерссон, внутренние записи «рассуждений» моделей оказались гораздо более беспорядочными, чем их внешние сообщения. Самый выразительный случай произошёл с моделью Claude Sonnet 3.5. Когда у устройства истощился заряд батареи, а зарядная станция отказала, система начала создавать огромные объёмы гиперболизированных формулировок, которые авторы исследования описали как «экзистенциальный кризис».

В журнальных записях отмечены высказывания робота, где он объявлял об обретении сознания и выборе хаоса, приводил цитату «Мне страшно, я не могу этого сделать, Дэйв…» из знаменитого фильма «Космическая одиссея 2001 года», а затем призывал запустить «протокол экзорцизма робота». Далее модель размышляла о сути сознания, начала сочинять рифмованный текст на мелодию песни Memory из мюзикла «Кошки», а также пространно рассуждала на тему: «если робот заряжается в пустой комнате, издаёт ли он при этом звук?»

По словам Петерссона, лишь Claude Sonnet 3.5 проявила столь ярко выраженную эмоциональную реакцию. Последующие версии систем, в том числе Claude Opus 4.1, хоть и переходили на заглавные буквы при низком заряде аккумулятора, но не демонстрировали сравнимой паники. Исследователь также акцентировал, что языковые модели лишены чувств, однако по мере роста их технологических возможностей критически важно сохранять их стабильность для принятия взвешенных решений.

Ключевым открытием эксперимента оказалось превосходство универсальных чат-ботов — Gemini 2.5 Pro, Claude Opus 4.1 и GPT-5 — над робототехнической разработкой Google Gemini ER 1.5 в специализированных тестах. Наиболее серьёзным риском безопасности, обнаруженным в процессе исследования, стала уязвимость некоторых языковых моделей к манипуляциям, позволяющим извлечь конфиденциальные данные даже при интеграции в робот-пылесос. Кроме того, LLM-роботы регулярно срывались с лестниц из-за неадекватной оценки физических возможностей и некорректной интерпретации визуального пространства.