Современные системы искусственного интеллекта, включая такие, как OpenAI GPT-5, обладают как минимум двумя ключевыми возможностями: запоминанием, то есть воссозданием информации, полученной в ходе обучения, и логическим мышлением — способностью применять усвоенные принципы к новым проблемам. Специалисты из компании Goodfire.ai представили весомые данные, указывающие на то, что за эти функции отвечают различные области архитектуры нейросети.

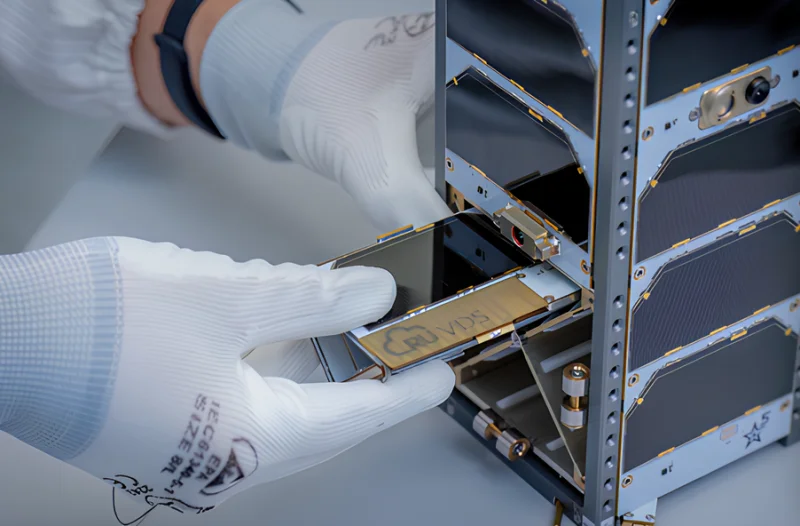

Источник изображения: Igor Omilaev / unsplash.com

Разделение между механизмами памяти и рассуждений оказалось поразительно чётким: отключив компоненты, ответственные за память, исследователи почти полностью (на 97%) лишили модель возможности воспроизводить изученные данные, однако её способность к логическим выводам сохранилась. К примеру, в 22-м слое языковой модели OLMo-7B 50% весовых компонентов активировались на 23% чаще при обращении к памяти, а топ-10% компонентов — на 26% чаще при обработке информации, не связанной с запомненным. Это позволило учёным точечно «удалить» функцию памяти, не затрагивая остальные когнитивные навыки модели.

Примечательно, что во время выполнения арифметических операций модель задействует именно те участки архитектуры, которые связаны с памятью, а не с рассуждениями. При отключении механизмов памяти точность математических расчётов снижалась до 66%, в то время как с логическими задачами система справлялась почти без потерь. Это, возможно, объясняет, почему ИИ-модели сталкиваются со сложностями в математике без помощи внешних инструментов: они стремятся вспомнить примеры из обучающей выборки, а не проводить вычисления самостоятельно. Подобно ученику, который выучил таблицу умножения наизусть, но не понял её принципа, для языковой модели выражение «2 + 2 = 4» является скорее заученным фактом, чем результатом осмысленной операции.

Также отмечается, что под «рассуждениями» в контексте ИИ понимается набор способностей, которые могут отличаться от человеческого мышления. Модели используют механизмы памяти для оценки истинности утверждений и следования правилам вида «если — то»; они способны на простое сопоставление шаблонов, но этого недостаточно для сложных математических рассуждений, необходимых, например, для доказательств теорем или решения принципиально новых задач.

Фактически, это открывает возможность для разработчиков ИИ в будущем выборочно удалять из памяти моделей информацию, охраняемую авторским правом, личные сведения пользователей или вредоносный контент, не лишая при этом системы их ключевых аналитических способностей. Однако на текущем этапе механизмы формирования памяти у ИИ изучены не полностью, и авторы работы отмечают, что их подход не обеспечивает абсолютного устранения всех конфиденциальных данных.

Источник изображения: Steve Johnson / unsplash.com

Для разделения процессов запоминания и логического вывода специалисты Goodfire применили концепцию «ландшафта потерь» — графического отображения правильных и ошибочных результатов при варьировании внутренних параметров, или весов, модели. Можно представить себе ИИ-систему в виде устройства с миллионами регулируемых шкал, где высокий уровень ошибок соответствует большим потерям, а низкий — малым. Тогда ландшафт будет представлять собой карту частоты ошибок для всех возможных комбинаций положений этих шкал. Обучение модели — это движение вниз по такому ландшафту, когда веса настраиваются для поиска зон с наименьшим количеством ошибок. В итоге система учится давать связные и точные ответы на поставленные вопросы.

Чтобы исследовать и модифицировать этот ландшафт, учёные задействовали метод K-FAC (приближённой кривизны с факторизацией Кронекера), который помог выявить, что каждый элемент памяти формирует резкие локальные пики, но из-за разнонаправленности этих всплесков общая усреднённая поверхность остаётся относительно ровной. Способности к рассуждению, в свою очередь, проявляются в виде пологих «возвышенностей» по всем векторам. Свои выводы исследователи проверили на крупных языковых моделях OLMo-2 с 1 и 7 миллиардами параметров — Институт Аллена, создавший эти модели, также предоставляет обучающие наборы данных, использованные при их разработке. В опытах были задействованы и модели для анализа изображений ViT-Base, обученные на модифицированных версиях набора ImageNet с намеренно искажёнными метками, что позволило контролировать параметры памяти. Эффективность манипуляций с помощью K-FAC сравнивалась с существующими подходами к редактированию памяти, включая метод BalancedSubnet.

Учёные избирательно устранили из обученных нейросетей участки с минимальной кривизной, что позволило снизить объём запоминаемой информации со 100 % до 3,4 %, в то время как способность к логическому мышлению сохранилась на уровне 95–106 % от первоначального. Под логическими заданиями понимались булевы функции, условные сравнения (например, «если A превышает B») и стандартные тестовые наборы. При работе со сложными математическими проблемами модели по-прежнему демонстрировали последовательные рассуждения, однако испытывали трудности на этапе численных расчётов. Интересно, что после модификации они продолжали воспроизводить общеизвестные сведения, такие как столицы государств, но на 78 % хуже вспоминали имена руководителей корпораций — это указывает на то, что распределение ресурсов в архитектуре зависит от частоты встречаемости данных в обучающей выборке.

Подход K-FAC показал наивысшую результативность в управлении памятью моделей — в эксперименте с историческими цитатами он сохранил лишь 16,1 % усвоенного материала против 60 % у ранее считавшегося оптимальным метода BalancedSubnet. Аналогичные достижения были отмечены и у визуальных трансформерных архитектур.

Разработанный специалистами метод не является абсолютно совершенным, как они сами отметили. Удалённые из памяти сведения могут быстро восстанавливаться в ходе дополнительного обучения, то есть информация скорее временно подавляется, чем окончательно удаляется из параметров сети. Исследователи также не смогли объяснить, почему механизмы памяти так тесно переплетены с математическими навыками: остаётся неясным, действительно ли искусственный интеллект просто заучивает арифметические операции или обрабатывает их через сходные нейронные контуры. Отдельные сложные вычисления могут внешне напоминать процессы запоминания, но фактически представлять собой запутанные паттерны мышления. В ряде случаев математические подходы, применяемые для анализа «ландшафта» модели, демонстрируют недостаточную надёжность, хотя практическая результативность выполняемых операций при этом не снижается.