Несмотря на то, что современные графические процессоры в основном оптимизированы для вычислений с пониженной точностью, которые востребованы в задачах искусственного интеллекта, операции с высокой точностью (FP64) остаются «крайне значимыми» для «Миссии Генезис» (Genesis Mission) и её цели — ускорения научного прогресса с помощью ИИ. Об этом в беседе с HPCwire заявил заместитель министра энергетики США по научной работе и инновациям Дарио Гил (Darío Gil).

«В ходе моих обсуждений с [генеральным директором AMD] Лизой Су (Lisa Su) и [генеральным директором NVIDIA] Дженсеном Хуангом (Jensen Huang) они чётко подтвердили свою приверженность поддержке формата FP64, заверив, что она будет продолжена, — отметил Гил. — Для нас это имеет большое значение, поскольку мы рассматриваем эти подходы не как замену, а как взаимодополняющие технологии». Он подчеркнул, что для выполнения как традиционных задач моделирования и симуляции, лежащих в основе научных расчётов, так и для новых методов ИИ, критически важно наличие высокопроизводительного аппаратного обеспечения.

Гил также добавил, что оба типа вычислений будут совместно способствовать достижению цели «Миссии Генезис» — расширению горизонтов науки и инженерии благодаря технологиям искусственного интеллекта. «Существуют высокоточные симуляционные коды, работающие с FP64. После их верификации они служат основой для создания данных, на которых обучается суррогатная модель, запускаемая затем на ИИ-суперкомпьютере, — пояснил он. — В результате вы получаете значительный выигрыш в производительности и скорости получения решений — часто в 10, 20 или даже 100 раз».

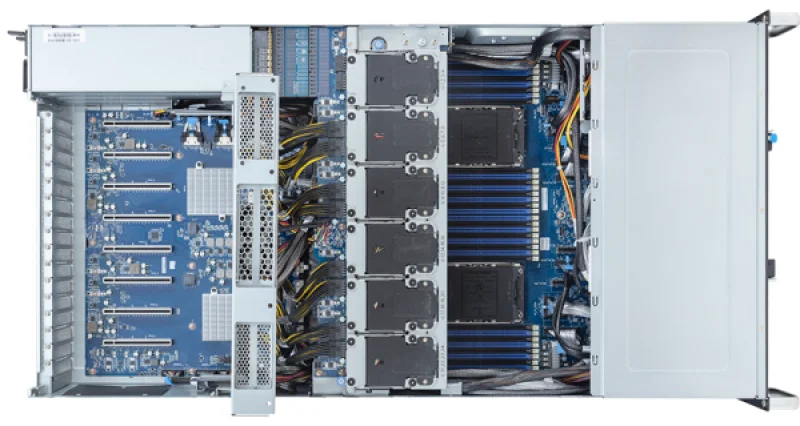

Источник изображений: NVIDIA

Он подчеркнул, что применение моделей искусственного интеллекта способно привести к значительному росту эффективности, однако этот рост обусловлен сохранением полного рабочего цикла, включающего эксперименты, симуляции и обучение. «Разрыв этого цикла, например, утрата исходного кода для моделирования, создаёт серьёзные трудности», — пояснил Гил. «Это принципиальный вопрос не только для поддержки унаследованных критически важных для миссии систем, но и для обеспечения функционирования самого ИИ-процесса. Вот почему для нас крайне важно сохранять разнообразие архитектурных решений», — добавил он.

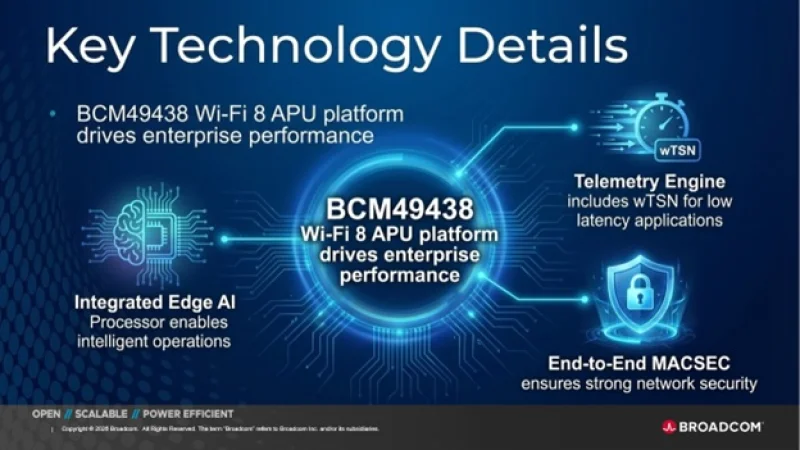

В среде высокопроизводительных вычислений (HPC) растёт беспокойство из-за отсутствия прогресса в производительности для операций с двойной точностью (FP64) в современных графических процессорах. Например, чип NVIDIA H100, представленный в 2022 году, демонстрирует 67 терафлопс в формате FP64 на тензорных ядрах (и 34 терафлопс на векторных), тогда как модель B200 предлагает лишь 37 терафлопс, а B300 — всего около 1,3 терафлопс. Программная эмуляция вычислений FP64 на тензорных ядрах архитектуры Blackwell позволяет достичь «нечестных» 150 терафлопс, а в новейшей архитектуре Rubin этот показатель возрастает до 200 терафлопс. При этом пиковая заявленная производительность векторных операций FP64 у Rubin составляет только 33 терафлопс, то есть никакого улучшения по сравнению с Hopper не наблюдается.

Стоит отметить, что в AMD подвергли эту стратегию критике, указав, что она подходит не для всех задач и потому не готова к массовому внедрению. В то же время специалисты предостерегают, что смещение акцента производителей на выпуск чипов для ИИ-нагрузок, оптимально работающих с низкоточными вычислениями, может вызвать дефицит процессоров с поддержкой FP64 для HPC, что ставит под угрозу лидерство США на данном рыночном сегменте.

По мере того как NVIDIA наращивает возможности архитектуры Rubin для выполнения ИИ-задач с низкой точностью, компания будет всё активнее использовать cuBLAS — библиотеку стандартных математических операций CUDA-X, которая эмулирует вычисления с двойной точностью на тензорных ядрах, чтобы последовательно повышать показатели производительности FP64. «Мы стремимся предоставить эти инструменты сообществу разработчиков, чтобы они могли… достигать требуемой точности FP64», — заявил в декабрьском интервью HPCwire Дион Харрис (Dion Harris), старший директор NVIDIA по решениям для ИИ и HPC у гиперскейлеров.

Производительность симуляции на GPU NVIDIA

Технологии NVIDIA для эмуляции высокой точности базируются на схеме Осаки, которая даёт возможность проводить матричные умножения с повышенной точностью за счёт многократных операций пониженной точности на тензорных ядрах. В NVIDIA считают такой подход обоснованным, так как наращивание производительности FP64 простым увеличением числа CUDA-ядер не приведёт к реальному росту эффективности в HPC-задачах, но снизит гибкость чипов. Как отмечает компания, изучение реальных рабочих нагрузок подтверждает, что «максимальная стабильная производительность FP64 чаще всего наблюдается именно при операциях умножения матриц». В архитектуре Hopper для этого существовали специализированные аппаратные блоки, однако в Blackwell и Rubin NVIDIA делает больший акцент на эмуляцию.

При этом производительность векторных вычислений FP64 остаётся крайне важной для научных расчётов, где матричные ядра не являются основными, признаётся в NVIDIA. Однако там же поясняют, что в подобных сценариях производительность чаще ограничена скоростью перемещения данных через регистры, кэши и память HBM, а не самими вычислительными мощностями. Поэтому сбалансированная архитектура GPU, по их словам, «предоставляет ровно столько ресурсов FP64, сколько нужно для полной загрузки доступной пропускной способности памяти, избегая неэффективного избыточного выделения вычислительных мощностей». Проще говоря, кардинальных изменений в подходе не планируется.

Проект Genesis Mission, вероятно, будет порождать разнообразные ИИ-приложения для научных и инженерных целей, и каждое из них, скорее всего, предъявит свои требования к вычислениям. Удалось ли NVIDIA и AMD найти идеальное соотношение, используя вычислительные ядра для матричных операций и полагаясь на эмуляцию по схеме Осаки для FP64, — этот вопрос пока остаётся открытым, отмечает HPCwire.

Источник: